|

|

|

December 1st, 2016

08:42 pm - Teaching achievements

Закончил читать свой первый полноценный курс по дистрибутивной семантике. Это был адский месяц, потому что всё нужно было делать почти с нуля, но я доволен. Закончил читать свой первый полноценный курс по дистрибутивной семантике. Это был адский месяц, потому что всё нужно было делать почти с нуля, но я доволен.

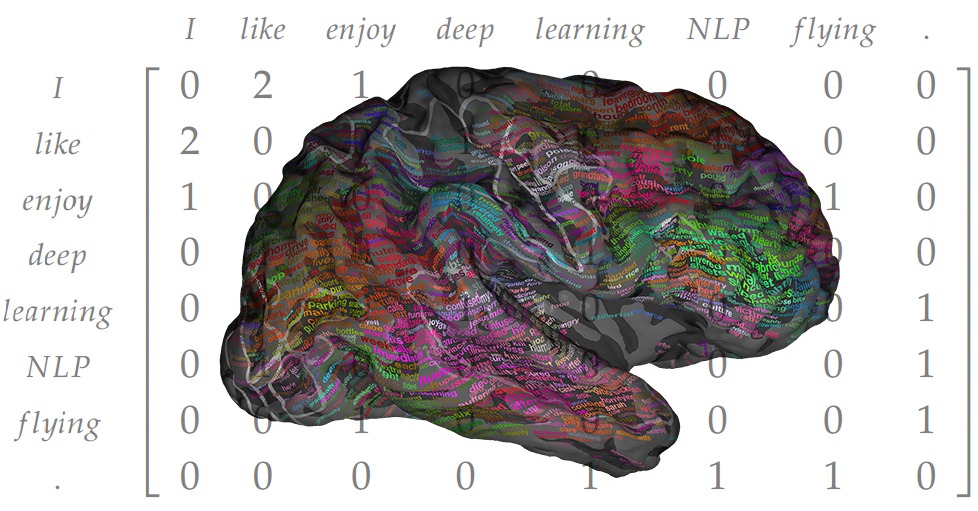

До этого были только какие-то отдельные лекции, доклады и тьюториалы, несистемно. Теперь есть прямо целый курс, шесть лекций, семинары, mandatory reading, obligatory assignment, экзамен, вот это всё. Конечно, можно сделать и получше (и побольше), но зато вроде бы получилось донести практически bleeding edge: предсказательные модели на нейронных сетях (word2vec и компания) и все модные темы, связанные с ними. Можно сказать, прямо с конференций в classroom. Кажется, так и надо.

Читалось как половина сборного курса Language technological applications (в первой половине давали машинный перевод). Тут слайды лекций, списки литературы, задания и прочий syllabus (во второй половине страницы).

Курс в основном для магистрантов факультета информатики, обучающихся на программе “Язык и коммуникация” (компьютерная лингвистика, короче). Бэкграунд у них очень разный (как всегда на NLP-программах), но вроде интерес проявляют и более-менее справляются. Посмотрим как напишут экзамен.

P.S. Это ещё был и первый опыт систематического преподавания в европейском университете, что тоже довольно интересно.

P.P.S. Не упускаю случая ещё раз порекламировать наш семантический калькулятор RusVectōrēs с дистрибутивно-семантическими моделями для русского. Скоро планируем выкатить тонну новых фич.

Current Music: Nick Cave & The Bad Seeds - Red Right Hand

|

Comments:

крутые Вы там! добавляю в друзья!

| From: | (Anonymous) |

|---|

| Date: | December 1st, 2016 - 10:42 pm |

|---|

| | | (Link) |

|

прикольно

а с помощью этих штук можно "устанавливать авторство текста"?

или такая задача:

вбрасываем в группу людей несколько текстов, в эти тексты закладываем "маркеры"

потом смотрим речь людей этой группы, пытемся увидеть эти "маркеры", то есть какие тексты повлияли на их речь

Скажем так, это может помочь в задаче установления авторства. В комплексе с другими методами.

| From: | (Anonymous) |

|---|

| Date: | December 1st, 2016 - 10:57 pm |

|---|

| | | (Link) |

|

то есть в принципе и для второй задачи может быть полезно

спасибо, будем посмотреть

| From: | (Anonymous) |

|---|

| Date: | December 1st, 2016 - 11:42 pm |

|---|

| | no comments | (Link) |

|

Семантические аналоги для культура (вычисленные на модели news)

мединский 0.435

минкультуры 0.428

культурный 0.425

журденов 0.410

минкульт 0.406

манилова 0.404

искусство 0.395

кинематография 0.389

культурно 0.379

наследие 0.379

Кто скажет что "мединский" плохой семантический ассоциат для "культуры" с точки зрения новостных текстов, тот пусть бросит в меня камень :)

| From: | (Anonymous) |

|---|

| Date: | December 1st, 2016 - 11:45 pm |

|---|

| | | (Link) |

|

Семантические аналоги для хохол (вычисленные на модели news)

кацап 0.480

ниггер 0.459

жид 0.390

ватник 0.383

быдло 0.374

матерный 0.365

америкос 0.363

бандеровец 0.362

малоросс 0.346

лексикон 0.342

особенно странно вот это

Семантические аналоги для ебать (вычисленные на модели news)

банкі 0.321

жинақ 0.308

ауытқу 0.307

банктердің 0.301

деңгейлі 0.292

қаулысымен 0.291

несие 0.289

туда 0.289

бағамының 0.288

қордан 0.287

причем для "жид" она вполне адекватно находит

а если посмотреть все 4 базы, получается так

НКРЯ и русская Wikipedia

перемать 0.408

ебеный 0.399

переебывать 0.362

перетака 0.336

едривать 0.299

едри 0.291

кузькин 0.291

чортовый 0.290

жидяра 0.289

хуй 0.279

НКРЯ

перемать 0.493

ебеный 0.475

пиздить 0.465

перетака 0.464

едри 0.439

блядь 0.431

трясця 0.408

ебаный 0.404

распречестный 0.402

ебаться 0.397

Веб-корпус

выебывать 0.802

трахнуть 0.771

трахать 0.764

ебаться 0.739

трахаться 0.697

телка 0.696

дрочить 0.692

ебля 0.677

жопа 0.671

сосать 0.648

Новостной корпус

банкі 0.321

жинақ 0.308

ауытқу 0.307

банктердің 0.301

деңгейлі 0.292

қаулысымен 0.291

несие 0.289

туда 0.289

бағамының 0.288

қордан 0.287

* * *

занятно, что при добавлении Википедии к НКРЯ вылезает слово "жидяра",

которого в НКРЯ нет

| From: | (Anonymous) |

|---|

| Date: | December 2nd, 2016 - 01:08 am |

|---|

| | | (Link) |

|

в чисто НКРЯ сходство даже выше, чем в википедии

просто в top не попало

Пары слов Косинусная близость

(НКРЯ)

ебать жидяра 0.318

Сравнивать косинусные близости между двумя разными моделями напрямую бессмысленно, они же (модели) не детерминированные.

Сравнивать списки ближайших ассоциатов гораздо полезнее.

| From: | (Anonymous) |

|---|

| Date: | December 2nd, 2016 - 04:54 pm |

|---|

| | | (Link) |

|

Тут как раз интересно, что в списках ассоциатов для одного слова в разных моделях раличный средний показатель сходства.

Плотность семантического пространства разная, да.

Может ничего не значить и быть просто следствием стохастической природы обучения моделей, а может быть системным свойством разных корпусов.

Нужно изучать.

| From: | (Anonymous) |

|---|

| Date: | December 2nd, 2016 - 12:49 am |

|---|

| | | (Link) |

|

из казахских новостей надёргали, бггг, еншілес банкі

Ничего странного же. Как ты думаешь, часто в новостных текстах встречается слово "ебать"? Нечасто. Так что и ассоциаты у него мусорные.

А казахские слова попадаются, потому что в нашем новостном корпусе есть какое-то количество казахских новостей. Мы как раз сейчас работаем над тем, чтобы отфильтровать все, что не русский.

слово жид тоже по идее не должно встречаться, а оно есть

Частотность на 2013-2015 годы:

2169 жид_S

288 ебать_V

В десять раз чаще употребляется в новостях.

| From: | (Anonymous) |

|---|

| Date: | December 2nd, 2016 - 04:51 pm |

|---|

| | | (Link) |

|

Комментарии пользователй новостных сайтов тоже используются? Или только тексты новостей?

По идее только тексты. Но конечно могло что-то по мелочи и из комментариев пролезть.

Часть "жидов" - это Андре Жид, кстати.

| From: | (Anonymous) |

|---|

| Date: | December 2nd, 2016 - 08:04 am |

|---|

| | | (Link) |

|

Это всё очень хорошо!

Отдельное спасибо за материалы!

| From: | (Anonymous) |

|---|

| Date: | December 2nd, 2016 - 01:37 pm |

|---|

| | | (Link) |

|

Очень интересно! Спасибо!

p.s. а лукетмиша идёт на хуй |

|